Raspberry Pi 5の16GBで日本語LLM「Llama-3-ELYZA-JP-8B」の量子化モデルを動かしてみました。

- 2025年2月23日

- 読了時間: 3分

更新日:2025年2月24日

Raspberry Pi 5の16GBで日本語LLM「Llama-3-ELYZA-JP-8B」の量子化モデルを動かしてみました。

いくつかある日本語LLMの中で決め手になったのは日本に関する質問ができそうだったのと量子化対応でセットアップが簡単そうだったことです。

以下セットアップの手順を書いていきます。

まず、Raspberry Pi imagerでmicro SD Cardにイメージファイルを書き込み、OSをインストールします。詳細な手順については割愛させていただきます。

日本語の設定をします。

sudo apt install fcitx-mozc

下記のコマンドでllama-cpp-pythonをインストールします。

pip install llama-cpp-python --break-system-packages

※「--break-system-packages」は、強制的にインストールするためのオプションです。これがないと、「externally-managed-environment」というエラーが発生し、インストールが中断してしまいます。

コマンドの実行後、画面に「Successfully installed」と表示されたら、インストールは成功です。

下記より、モデルをダウンロードします。

https://huggingface.co/elyza/Llama-3-ELYZA-JP-8B-GGUF/tree/main

ダウンロードが完了したら、適当な場所に作業用のフォルダーを作って、その中に格納します。

以上で設定は完了です。

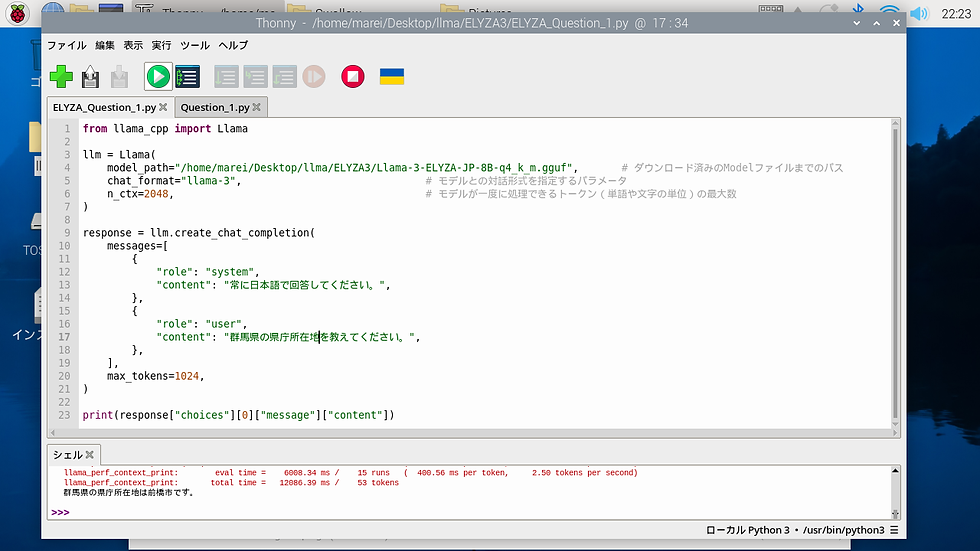

Pythonの場合プログラム

ネットで検索して、下記のプログラムをベースに実行しています。

私の場合はThonnyで開き実行しています。

質問への返答時間は最初の質問に対しては数分程度かかりますが、2問目以降は1分以内に返答している感じです。

なお、今回質問してみた内容がこちらです。

質問1 世界で一番高い山を教えてください。

正解です。

質問2 日本で一番高い山を教えてください。

不正解です。

質問3 群馬県の県庁所在地を教えてください。

正解です。

2問目の日本一高い山については質問の仕方を変えてみてもダメでした。

量子化モデルでないデモ版で確認したときはきちんと答えてくれていたのですが、やはり多少の精度の低下はあるのかと思います。

もういくつか気になる量子化モデルがあるので、そちらでも試してみたいと思います。

その他、ノーコードで呼び出す方法としてLM Studioをダウンロードしてインストールするとノーコードで動かすことができるようなのですが、残念ながらRaspberry Piは対象外のようです。

今後、GUI化するなどして使いやすくしていきたいと思います。

参考にさせていただいた記事

・note 「GPT-4」を上回る日本語性能のLLM「Llama-3-ELYZA-JP」を開発しました

・Hugging Face elyza/Llama-3-ELYZA-JP-8B-GGUF

・EeePCの軌跡 Raspberry Pi 5に日本語LLM(ELYZA-Japanese-Llama-2-7b-fast-Instruct)を入れてみた

・日経XTECH ラズパイ5でLLMを動かしてみよう、チャットAIのGUIアプリを作成

・Raspberry Pi 5 でTinyLlamaを試してみた

・【LLM最新版】おすすめ日本語対応ローカルAIモデル8選!」

・【推し】現在利用しているローカルLLM【日本語LLM】

・Qiita @kansou in 株式会社オフグリッド CPUだけでローカルLLM(GPU不使用)

・excite Tech Blog Local LLMをサクッと動作させてみる

・Qiita @kenta1984(Kenta Sasaki) 日本語のローカルLLM(文章生成AI)をWindowsで動かす

・売る力【コピペでOK】ローカルLMM(AI)をまずは動かしてみよう!

コメント